AI Meets Archives

Motivation

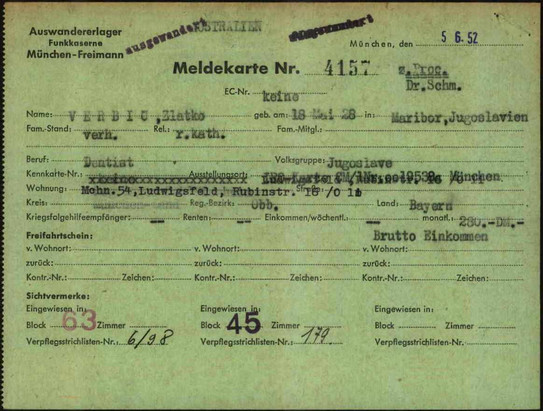

Archive bewahren vielfältige und wertvolle Datenbestände auf, die die Grundlage für historische, rechtliche und wissenschaftliche Forschungen bilden. Dazu zählen zum Beispiel amtliche Dokumente wie Verwaltungsakten und Gesetze sowie Personenstandsunterlagen, wie Geburts- und Sterberegister. Diese einzigartigen und oft schwer zugänglichen Quellen sind jedoch häufig unzureichend indexiert, was die Wissensextraktion enorm erschwert. Die Indexierung dieser Bestände ist für Gesellschaftswissenschaftler wie z.B. der Arbeitsgruppe für Neueste Geschichte und Historische Migrationsforschung der Universität Osnabrück von höchster Relevanz. Die Mächtigkeit der Archivbestände ist enorm. Einige Beispiele bilden die CM1-Akten des Arolsen Archivs (siehe rechts) mit ca. 120.000 Bögen, die Volkszählung NRW von 1950 mit ca. 4,25 Mio. Erhebungsbögen (siehe rechts) oder die Entnazifizierungsakten NRW mit ca. 1,2 Mio. Akten zu mehr als 802.000 Personen. Manche davon sind öffentlich zugänglich, aber nur wenige sind als elektronischer Volltext verfügbar und daher schwer zu durchsuchen. Noch Heute erfolgt die Erschließung solcher Bestände manuell und ist damit enorm zeit- und kostspielig.

Aufgabenstellung

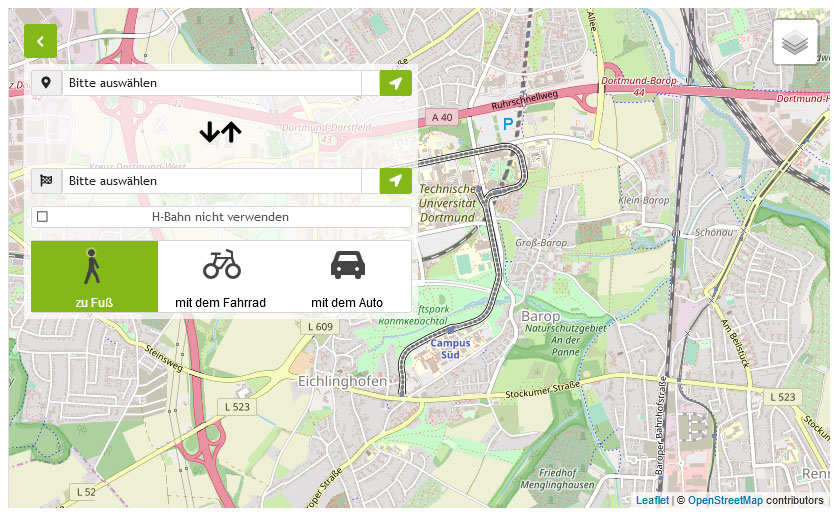

Ziel der Projektgruppe ist der Entwurf eines KI-Systems, das Archivbestände wie Personenkarteien automatisiert erschließt und diese zur nachgelagerten Wissensexploration effizient zugänglich macht. Die Aufgabe kann zum Beispiel auf den öffentlich verfügbaren und in Teilen bereits transkribierten CM1-Akten des Arolsen Archivs umgesetzt und getestet werden. Neben der Extraktion von personenbezogenen Daten zur Indexierung der Karteien lassen sich weitere Informationen für komplexere Analysen automatisiert erfassen. Beispielweise etwa die Erkennung der Wohnorte und Umzüge, um Muster in Migrationen aufzudecken, oder die Schreiberidentifikation anhand von Unterschriften, um Korrelationen zwischen Sachbearbeitern und Entscheidungen aufzudecken. Bei der Durchführung wird die Projektgruppe von den Kooperationspartnern der Universität Osnabrück unterstützt. Diese fungieren sowohl als Experten, welche Hilfestellungen zu relevanten Forschungsfragen bieten können, als auch als fiktive Kunden. Diese wertvolle Zusammenarbeit ermöglicht es, sich in interdisziplinärer Kommunikation zu üben und Perspektiven fachfremder Mitarbeiter zu verstehen. Im Folgenden werden die für das Projekt relevanten Methoden kurz beschrieben.

Visual Question Answering

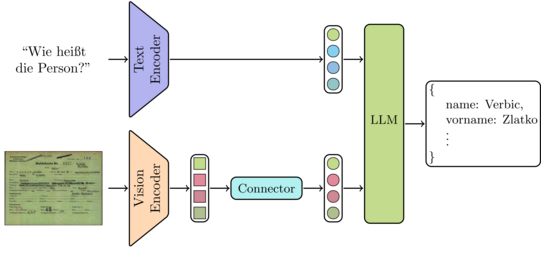

Visual Question Answering (VQA) [7] ist ein Forschungsgebiet der Computer Vision, bei dem Systeme entwickelt werden, die auf Basis von Bilddaten und einer sprachlichen Frage Informationen aus den Bildern extrahieren und beantworten können. VQA kombiniert Bild- und Sprachverstehen, um aus visuellen Inhalten (wie Fotos oder Videos) relevante Details herauszulesen und zu interpretieren. Das Ziel ist es, Systeme zu schaffen, die Fragen über Bildinhalte präzise und kontextbezogen beantworten.

Ein Beispiel für VQA im Kontext von Archivdaten ist die simple Frage welche Namen auf einer gegeben Kartei zu lesen sind. Komplexere Anfragen können z.B. den Wohnort bzw. Umzüge, die Geburts- oder Sterbedaten oder eine Liste der Familienmitglieder erfragen.

Generative KI

In den letzten Jahren gewann Generative KI durch KI-Assistenten wie ChatGPT, Gemini und Co. zunehmend an Bedeutung. Implementiert werden diese durch Large Language Models (LLMs) [2, 4, 6]. Diese sind Sprachmodelle, welche durch große Transformer Modelle angetrieben werden. Ein Sprachmodell ist ein Modell, das darauf trainiert ist, Texte zu verstehen und zu generieren, indem es statistische Muster und Zusammenhänge in großen Mengen von Textdaten erkennt. Es wird verwendet, um Aufgaben wie Textvervollständigung, maschinelle Übersetzung oder Sprachklassifikation auszuführen, indem es die Wahrscheinlichkeit für das Auftreten bestimmter Wörter oder Wortfolgen berechnet. Entsprechend sind Large Language Models Sprachmodelle, die sowohl in ihrer Parameterzahl als auch in der Menge der Traningsdaten enorm hochskaliert wurden. Aufgrund der erstaunlichen Leistungen von LLMs im Bereich des zero-shot und few-shot learnings ergibt sich unmittelbar eine Vielzahl von Einsatzmöglichkeiten. Oftmals genügt die Verwendung von vortrainierten LLMs bereits ohne weiteres fine-tuning, nur durch die Wahl geeigneter Eingaben (Prompts). Weiterentwicklungen

ermöglichen zusätzliche Modalitäten bei der Eingabe, wie z.B. Bilder oder Ton, daher der Name Multimodal Large Language Models (MLLMs) [8]. Ein Spezialfall bilden Vision-Langauge Models (VLMs), bei denen die hinzugefügte Modalität sich auf Bilder beschränkt. Ziel von VLMs ist, beide Modalitäten in einem gemeinsamen Merkmalsraum zu verbinden. Dadurch kann die durch Textdaten gelernte Semantik genutzt werden, um Struktur in die hohe Variabilität von Bildern zu bringen. Modelle wie PaliGemma [1] gehen daher von einem gelernten Sprachmodell aus und fügen eine Projektion der vektoriellen Bildrepräsentationen in den Vektorraum der Textrepräsentationen durch einen trainierbaren Connector hinzu. Die Repräsentation des Bildes und des Prompts werden dadurch zu einem Eingabevektor für das Sprachmodell kombiniert, welches die Informationen decodiert und als Text ausgibt. Durch geeignet gewählte Prompts lässt sich das System für verschiedene Aufgaben nutzen. Um selbst Forschung und Entwicklung mit LLMs zu betreiben existieren offene Modelle wie LLaMa [6] oder Mistral [4], sowie offenen VLMs wie Idefics [5] und PaliGemma [1]. Die Verwendung von VLMs für die Erschließung von Archivbeständen ist daher ein logischer Schritt.

Effizientes Fine-Tuning

Für das Anpassen von LLMs an neue Aufgaben auf Consumer Hardware sind Methoden des effizienten Fine-Tunings notwendig, da ein klassisches Training mit einem enorm hohen Speicherbedarf einher geht (z.B. 1,2 TB VRAM zum Training von GPT-3). Ein Beispiel einer solchen Methode ist Low-Rank Adaptation (LoRA) [3]. Dabei werden die Hauptparameter des Modells "eingefroren" und durch zusätzliche Matrizen mit geringem Rang hinzugefügt. Diese arbeiten Parallel zu den bestehenden Schichten und werden beim Training an einer spezifische Aufgabe angepasst. Eine weitere Möglichkeit ist das Einfügen von kleinen Adapter-Schichten in das Modell. Ähnlich wie bei LoRA, werden nur die hinzugefügten Schichten trainiert, während die originalen Parameter unverändert bleiben.

Literatur

[1] Lucas Beyer, Andreas Steiner, André Susano Pinto et al.: PaliGemma: A Versatile 3B VLM for Transfer. In: arXiv preprint arXiv:2407.07726 (2024).

[2] Tom Brown, Benjamin Mann und Nick Ryder: Language Models are Few-Shot Learners. In: Advances in Neural Information Processing Systems. Bd. 33. 2020, S. 1877–1901.

[3] Edward J. Hu, Yelong Shen und Phillip Wallis: LoRA: Low-Rank Adaptation of Large Language Models. In: arXiv preprint arXiv:2106.09685 (2021).

[4] Albert Q Jiang, Alexandre Sablayrolles, Arthur Mensch et al.: Mistral 7B. In: arXiv preprint arXiv:2310.06825 (2023).

[5] Hugo Laurençon, Andrés Marafioti, Victor Sanh und Léo Tronchon: Building and Better Understanding Vision-Language Models: Insights and Future Directions. In: arXiv preprint arXiv:2408.12637 (2024).

[6] Hugo Touvron, Louis Martin, Kevin Stone et al.: Llama 2: Open Foundation and Fine-tuned Chat Models. In: arXiv preprint arXiv:2307.09288 (2023).

[7] Qi Wu, Damien Teney, Peng Wang et al.: Visual Question Answering: A Survey of Methods and Datasets. In: Computer Vision and Image Understanding 163 (2017), S. 21–40.

[8] Shukang Yin, Chaoyou Fu, Sirui Zhao et al.: A Survey on Multimodal Large Language Models. In: arXiv preprint arXiv:2306.13549 (2023).

![[Translate to English:] [Translate to English:]](/storages/zentraler_bilderpool/_processed_/4/b/csm_Ku__nstliche_Intelligenz_Pixabay_7559331fd1.jpg)

![[Translate to English:] [Translate to English:]](/storages/zentraler_bilderpool/_processed_/3/a/csm_Arbeitsplatz-Laptop-Notizbuch_02_ea47030ac6.jpg)

![[Translate to English:] [Translate to English:]](/storages/patrec-cs/_processed_/7/f/csm_lecture_41ff85494b.png)