Smart Shopping Assistant

Motivation

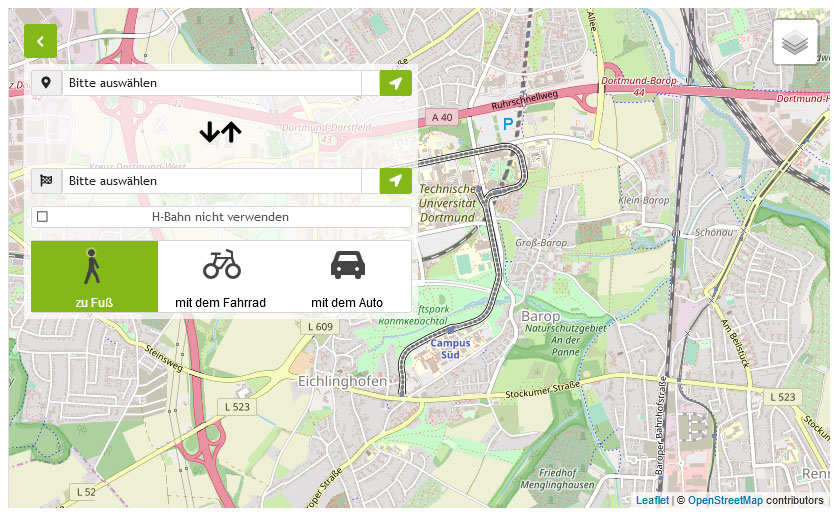

In der heutigen Zeit macht es uns Technologie wie zum Beispiel GPS einfach, uns in unserer Umwelt zu orientieren. Um von A nach B zu gelangen reichen ein paar Klicks und wir wissen unter anderem die genaue Entfernung, Verkehrslage, sowie Reisezeit. Die Route können wir bereits im Vorfeld Schritt für Schritt durchgehen oder uns live navigieren lassen. Oft merkt man erst wie man sich darauf verlässt, wenn diese Technologie nicht zur Verfügung steht. Dies ist besonders in geschlossenene Räumen, wie z.B. Flughäfen, Einkaufszentren, Stadien o.ä. der Fall, da dort die Satellitenverfügbarkeit gering ist. Aber auch in kleineren Gebäuden, wie z.B. Supermärkten, wäre aus Sicht der Kunden:innen eine effizientere Navigation zu ihren Produkten wünschenswert (siehe Abbildung 1).

Aktuelle Fortschritte in der Indoor-Navigation verwenden Arrays von WLAN-Access-Points oder sogenannte Bluetooth-Beacons, dessen Signalstärke an der aktuellen Position gemessen und somit auf diese zurückgeführt werden kann. Die Genauigkeit der Positionsbestimmung liegt hier bei etwa 1-3 Metern. Die Nachteile dieser Ansätze liegen auf der Hand: Viel Hardware muss angeschafft werden um eine einigermaßen genaue Positionierung zu ermöglichen und dabei ist diese in gewissen Anwendungsszenarien nicht einmal genau genug. Eines dieser Szenarien ist die Navigation in Supermärkten. Um einen/eine Benutzer:in hier zum gewünschten Produkt zu führen, reicht eine grobe Lokalisierung nicht aus. Die Unterstützung muss über diese hinaus gehen und sogar die Identifikation der Produkte in einem Regal ermöglichen. An diesem Punkt ist der bisher verwendete Beacon Standard unzureichend und kann lediglich zur Navigation auf Regalebene verwendet werden. Für die Produktidentifikation im Regal ist dann jedoch ein weiterer Navigationsschritt notwendig. Hierbei ist ein auf visueller Perzeption basierender Ansatz am vielversprechendsten, da dieser sowohl kostengünstig als auch sehr variabel ist. Hinzu kommt, dass die Leistungsfähigkeit dieser Systeme gerade in den letzten Jahren aufgrund der großen Fortschritte in den Bereichen der künstlichen Intelligenz und Mustererkennung stark verbessert werden konnte. Dabei ist jedoch zu beachten, dass dieser Fortschritt nicht ohne performantere Hardware möglich gewesen wäre. Da heutzutage jedoch selbst Smartphones in der Lage sind Algorithmen und Modelle der Mustererkennung, wie neuronale Netze es sind, lokal auszuwerten, können für das obige Problem völlig neue Ansätze entwickelt werden. Somit könnte eine auf visueller Wahrnehmung basierende Indoor-Navigation zu einem sehr großen Teil lokal auf den Endbenutzergeräten laufen und dadurch deutlich unabhängiger von aufwendigen Hardwareinstallationen sein. Dies würde eine unkomplizierte und kostengünstige Skalierung ermöglichen.

Um die Indoor-Navigation noch benutzerfreundlicher zu gestalten, können zudem aktuelle Ansätze aus dem Gebiet der Augmented Reality verwendet werden. Dadurch bekommt der/die Benutzer:in eine natürliche Schnittstelle zu diesen technischen Errungenschaften und kann zusätzliche Informationen unauffällig in die Umwelt einbetten.

Bitte bestätigen Sie die Aktivierung dieses Videos.

Nach der Aktivierung werden Cookies gesetzt und Daten an YouTube (Google) übermittelt.

Zur Datenschutzerklärung von Google

Bitte bestätigen Sie die Aktivierung dieses Videos.

Nach der Aktivierung werden Cookies gesetzt und Daten an YouTube (Google) übermittelt.

Zur Datenschutzerklärung von Google

Aufgabenstellung

Die Teilnehmer:innen sollen einen Shopping Assistenten entwickeln, welcher die Navigation für einen Einkauf im Supermarkt erleichtert und optimiert. Für die Realisierung dieses Assistenten sollen die Studierenden auf aktuelle Ansätze aus der Mustererkennung, sowie der Augmented Reality zurückgreifen.

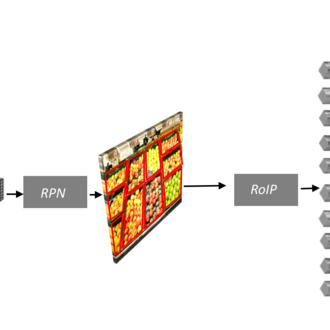

Mithilfe des Shopping Assistenten soll ein/eine Kunde/Kundin des Supermarktes zunächst auf seinem Smartphone eine Einkaufsliste erstellen können. Auf Grundlage dieser Liste wird der/die Kunde/Kundin anschließend auf dem effizientesten Wege zu den Produkten geführt. Hierbei sollen die Wege mithilfe der Augmented Reality [1,2] auf dem Smartphone angezeigt werden. Da eine genaue Navigation zu den Produkten mit den aktuellen Ansätzen sehr aufwendig bzw. nicht möglich ist, soll die Navigation nur bis zu den entsprechenden Regalen stattfinden. Wenn der/die Nutzer:in an einem Regal angekommen ist, kann er mithilfe seiner Smartphone Kamera das entsprechende Produkt im Regal identifizieren (siehe Abbildung 2).

Auf Grundlage dieser Beschreibung, kann die Entwicklung des Prototypen in drei Teilprobleme unterteilt werden:

- Erstellung einer Augmented Reality Smartphone Applikation

- Produkterkennung in Regalsystemen mithilfe von visueller Perzeption durch Mustererkennungssysteme

- Indoor Lokalisierung und Navigation zu Regalsystemen

Dabei sollen die Nutzenden mithilfe der Smartphone Applikation ihre Einkäufe planen können und anschließend mit Augmented Reality effizient durch den Supermarkt geführt werden. Dadurch können nicht nur die Wege zu den Regalen im Supermarkt, sondern auch zusätzliche Informationen zu den Produkten angezeigt werden. Außerdem dient die App als Schnittstelle für die Produktlokalisierung im Regal, da dort die Ergebnisse des visuellen Mustererkennungssystems angezeigt werden sollen.

Das Hauptziel der Projektgruppe ist die Identifikation und Lokalisierung von Produkten in Regalsystemen, welches mithilfe von einem Mustererkennungssystem, wie zum Beispiel einem Neuronalen Netz, erreicht werden kann. Hierzu gibt es in der Literatur sowohl Datensätze [4,5,6], Competitions als auch vielversprechende Ansätze zur Lösung des Problems [5,7]. Eine weitere Herausforderung für die praktische Anwendbarkeit ist zudem, dass die Identifikation und Lokalisierung möglichst ressourcensparend sein sollte, damit die Applikation lokal auf einem Smartphone oder Nvidia Jetson (siehe Abbildung 3) ausgeführt werden kann. Außerdem ist für die Entwicklung eines solchen Mustererkennungssystems die Auswahl beziehungsweise Erstellung eines geeigneten Datensatzes notwendig. Dieser könnte beispielsweise aus dem SKU-110K Datensatz [5] oder selbst annotierten Bildern aus dem Internet bestehen. Der SKU-110K-Datensatz bietet dabei den Vorteil, dass er insgesamt 11.762 Bilder von dicht gepackten Supermarktregalen auf der ganzen Welt enthält und bereits segmentiert, sowie annotiert wurde. Außerdem war der Datensatz Bestandteil von einer Challenge auf der CVPR 2020 und unterstreicht damit die Bedeutung dieser Daten für die aktuelle Forschung.

Für die Realisierung und Evaluation des Prototypen kann die Projektgruppe ein möglichst reales und kostengünstiges Szenario entwickeln, indem zunächst Bilder von Produktregalen auf Stellwände geheftet werden. Dies ermöglicht den Aufbau eines platzsparenden und kostengünstigen Supermarktes, bei dem ein schneller Sortimentenwechsel möglich ist. Um die Evaluation noch realer zu gestalten, können zudem echte Produktregale hinzugenommen werden.

Die Aufgabenstellung bietet zudem zahlreiche Erweiterungs- sowie Optimierungsmöglichkeiten, welche von der Projektgruppe ganz flexibel definiert und umgesetzt werden können. Dazu zählt z.B. der Einsatz einer Virtual Reality Brille (siehe Abbildung 4), wodurch der/die Nutzer:in den Weg zu den Produkten direkt in seinem Blickfeld sehen kann.

Literatur

[1] Dimitris Chatzopoulos and Carlos Bermejo and Zhanpeng Huang and Pan Hui, . "Mobile Augmented Reality Survey: From Where We Are to Where We Go". IEEE Access 5. (2017): 6917–6950.

[2] Harshal Deore and Akshat Agrawal and Vivek Jaglan and Pooja Nagpal and Mayank Mohan Sharma, . "A New Approach for Navigation and Traffic Signs Indication Using Map Integrated Augmented Reality for Self-Driving Cars". Scalable Comput. Pract. Exp. 21. 3(2020): 441–450.

[3] Jaime Duque Domingo and Carlos Cerrada and Enrique Valero and José A. Cerrada, . "Indoor Positioning System Using Depth Maps and Wireless Networks". J. Sensors 2016. (2016): 2107872:1–2107872:8.

[4] Patrick Follmann and Tobias Böttger and Philipp Härtinger and Rebecca König and Markus Ulrich, . "MVTec D2S: Densely Segmented Supermarket Dataset." ECCV.

[5] Eran Goldman and Roei Herzig and Aviv Eisenschtat and Jacob Goldberger and Tal Hassner, . "Precise Detection in Densely Packed Scenes." CVPR 2019.

[6] Philipp Jund and Nichola Abdo and Andreas Eitel and Wolfram Burgard, . "The Freiburg Groceries Dataset". CoRR abs/1611.05799. (2016).

[7] Tsung-Yi Lin and Priya Goyal and Ross B. Girshick and Kaiming He and Piotr Dollár, . "Focal Loss for Dense Object Detection". IEEE Trans. Pattern Anal. Mach. Intell. 42. 2(2020): 318–327.

![[Translate to English:] [Translate to English:]](/storages/zentraler_bilderpool/_processed_/4/b/csm_Ku__nstliche_Intelligenz_Pixabay_7559331fd1.jpg)

![[Translate to English:] [Translate to English:]](/storages/zentraler_bilderpool/_processed_/3/a/csm_Arbeitsplatz-Laptop-Notizbuch_02_ea47030ac6.jpg)

![[Translate to English:] [Translate to English:]](/storages/patrec-cs/_processed_/7/f/csm_lecture_41ff85494b.png)